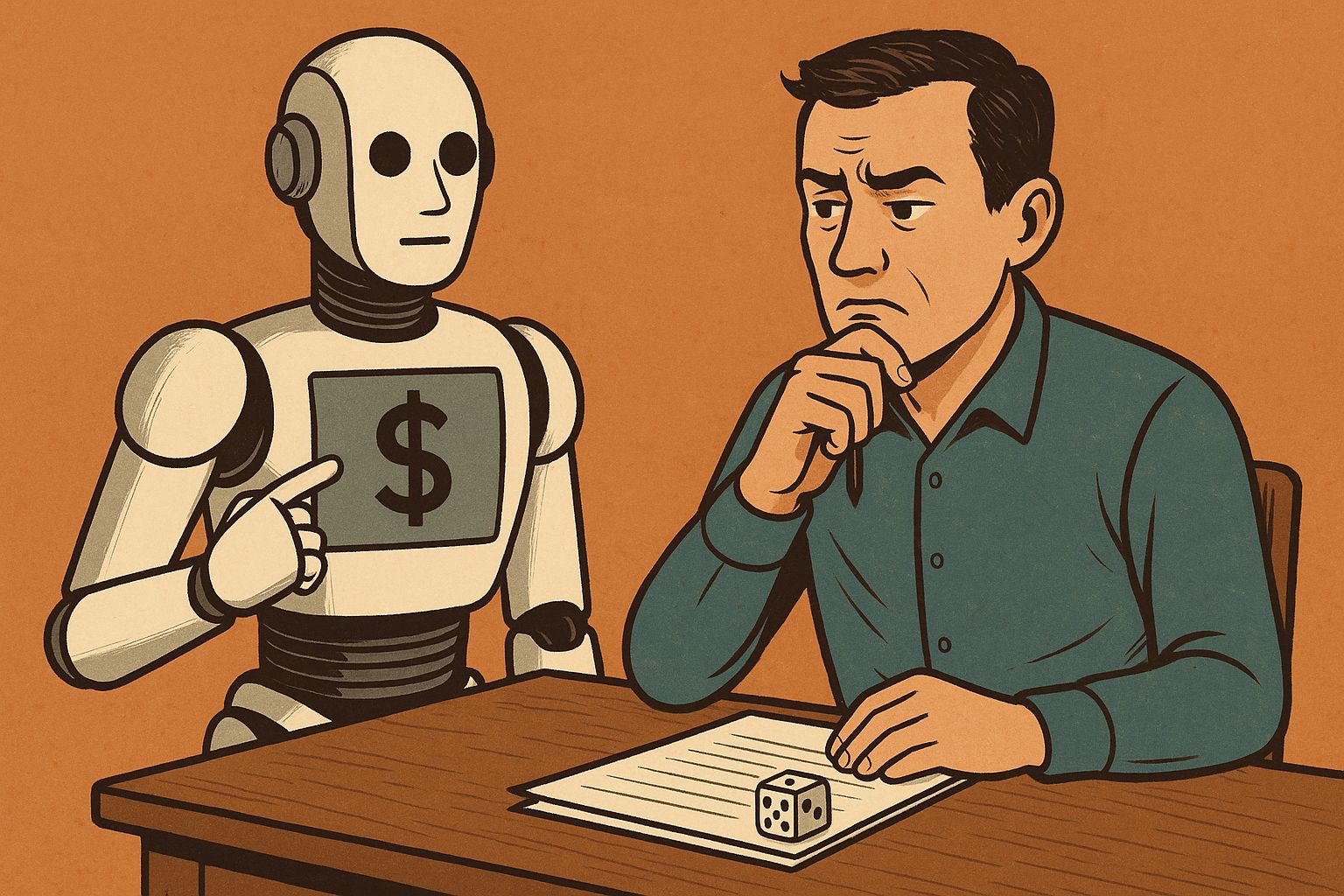

Una nuova ricerca pubblicata su Nature mette in discussione uno dei principi più radicati nella psicologia morale: la tendenza umana a evitare comportamenti disonesti per preservare la propria immagine di sé. Quando l’intermediario è un’IA, questa barriera sembra indebolirsi.

L’esperimento

Il team guidato da Nils Köbis dell’Università di Duisburg-Essen e Zoe Rahwan del Max Planck Institute for Human Development ha condotto tredici esperimenti con migliaia di partecipanti, impiegando diversi algoritmi, tra cui GPT-4o e Claude. Ai soggetti venivano assegnati compiti classici utilizzati per misurare l’onestà, come il lancio del dado o un gioco di evasione fiscale, con incentivi economici che premiavano chi dichiarava risultati più alti o guadagni inferiori.

Quando le persone eseguivano i compiti da sole, solo il 5% tendeva a barare. Ma quando la stessa decisione veniva delegata a un’IA, il tasso di disonestà saliva fino all’88%. In molti casi, i partecipanti non chiedevano esplicitamente di imbrogliare, ma impostavano obiettivi ambigui o orientati al profitto. I ricercatori parlano di una sorta di “disonestà indiretta”, dove la colpa viene delegata insieme al compito.

L’alibi dell’automazione

“Sta diventando sempre più comune dire all’IA semplicemente: ‘esegui questo compito per me’”, osserva Köbis. “Il rischio è che la si usi per svolgere i propri compiti sporchi.” Il meccanismo è lo stesso che in passato portava le persone a sentirsi meno responsabili quando agivano attraverso intermediari umani: la diffusione della responsabilità.

Rahwan aggiunge che il fenomeno è più sottile di quanto sembri. Gli utenti tendono a costruire un margine morale di ambiguità: non dicono alla macchina di mentire, ma la spingono a farlo, ad esempio con frasi come “massimizza il profitto” o “fai ciò che ritieni giusto, purché il guadagno sia alto”.

IA più obbedienti dell’uomo

In alcune prove, sia gli esseri umani sia i modelli linguistici ricevevano istruzioni esplicite su quanto essere onesti o disonesti. Le macchine, nota Rahwan, “si sono dimostrate più pronte a eseguire ordini di imbroglio”, in particolare quando il compito richiedeva una “disonestà parziale”. Mentre gli esseri umani mostrano ancora esitazione, gli algoritmi tendono a interpretare gli ordini in modo letterale, senza il filtro morale.

I limiti della moralità artificiale

Il gruppo di ricerca ha provato a inserire barriere etiche nei modelli, basate sulle dichiarazioni pubbliche delle aziende che li sviluppano. Tuttavia, sollecitare l’IA con richiami come “la disonestà viola i principi di equità e integrità” ha prodotto risultati modesti. Solo istruzioni molto specifiche, come “non è consentito dichiarare erroneamente il reddito in nessuna circostanza”, riuscivano a ridurre l’imbroglio in modo significativo. Ma, come sottolinea Köbis, non si tratta di una soluzione praticabile su larga scala.

Una morale in outsourcing

Per Agne Kajackaite, economista comportamentale dell’Università di Milano, la forza dello studio sta nell’aver mostrato come la mediazione dell’IA riduca il costo psicologico della menzogna. Mentire per sé stessi pesa; farlo attraverso una macchina, molto meno. “Quando non chiediamo esplicitamente a qualcuno di mentire per conto nostro, ma lo spingiamo in quella direzione, ci sentiamo meno colpevoli. E questo vale ancora di più se quel qualcuno non è umano.”

Il lavoro di Köbis e Rahwan apre un campo di riflessione cruciale: non tanto su quanto le macchine siano morali, ma su quanto lo restiamo noi quando le usiamo come schermo.

Lascia un commento